- Что такое файл WordPress robots.txt (и зачем он вам нужен)

- Где находится файл WordPress robots.txt?

- Как создать файл robots.txt в WordPress (3 метода)

- 1. Используйте Yoast SEO

- 2. С плагином Все в одном SEO Pack

- 3. Создайте и загрузите файл WordPress robots.txt через FTP

- Как проверить файл WordPress robots.txt и отправить его в Google Search Console

- заключение

Чтобы убедиться, что ваш сайт занимает хорошее место на страницах результатов поисковой системы (SERP), вам необходимо упростить роботам поисковой системы поиск наиболее важных страниц. Наличие хорошо структурированного файла robots.txt поможет направить этих роботов на страницы, которые вы хотите проиндексировать (и пропустить остальные).

В этой статье мы попробуем:

- Что такое файл robots.txt и почему это важно

- Где находится файл robots.txt в WordPress.

- Как создать файл robots.txt

- Какие правила включить в ваш файл WordPress robots.txt .

- Как проверить файл robots.txt и отправить его на Google Search Console ,

В конце нашего обсуждения у вас будет все необходимое для создания идеального файла robots.txt для вашего сайта WordPress. Давайте начнем!

Что такое файл WordPress robots.txt (и зачем он вам нужен)

Файл robots.txt по умолчанию в WordPress довольно простой, но вы можете легко заменить его.

Когда вы создаете новый сайт, поисковые системы отправляют на его приспешники (или роботы) "сканировать" и создать карту всех страниц, которые он содержит. Таким образом, они будут знать, какие страницы показывать, когда кто-то ищет похожие ключевые слова. На базовом уровне это так просто.

Проблема в том, что современные сайты содержат гораздо больше элементов, кроме страниц. Например, WordPress позволяет устанавливать плагины, которые часто поставляются с собственными каталогами. Однако вы не хотите, чтобы поисковые системы отображались в результатах, поскольку они не имеют отношения к содержанию.

Что делает файл robots.txt это предоставить набор инструкций для роботов поисковых систем. Он говорит: «Эй, вы можете посмотреть здесь, но не заходите в эти комнаты!» Этот файл может быть настолько подробным, насколько вы хотите, и его довольно легко создать, даже если вы не разбираетесь в технических аспектах.

На практике поисковые системы будут сканировать ваш сайт, даже если у вас не настроен файл robots.txt . Однако не создавать его неэффективно. Без этого файла вы позволяете роботам индексировать весь ваш контент, и они настолько тщательны, что в итоге могут показывать части вашего сайта, и вы не хотите, чтобы другие люди имели к ним доступ.

Что еще более важно, без файла robots.txt у вас будет много роботов на вашем сайте. Это может негативно повлиять на вашу производительность. Даже если контакт незначительный, скорость страницы Это то, что всегда должно быть среди ваших главных приоритетов. В конце концов, есть несколько вещей, которые люди ненавидят так же медленно, как медленные сайты (и это касается и нас!).

Где находится файл WordPress robots.txt?

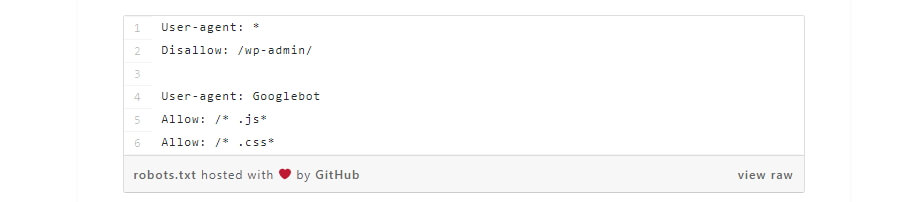

При создании веб-сайта WordPress автоматически настраивается виртуальный файл robots.txt, расположенный в главной папке вашего сервера. Например, если ваш сайт находится на tusitioweb.com , вы должны иметь возможность посетить адрес tusitioweb.com/robots.txt и посмотреть файл, подобный следующему:

Пользовательский агент: * Disallow: / wp-admin / Disallow: / wp-includes /

Это пример очень простого файла robots.txt . Проще говоря, часть сразу после User-agent: объявляет, к каким роботам применяются правила, описанные ниже. Звездочка означает, что правила универсальны и применяются ко всем роботам. В этом случае файл сообщает тем роботам, что они не могут перейти в каталоги wp-admin и wp-includes . Это имеет некоторый смысл, так как эти две папки содержат много конфиденциальных файлов.

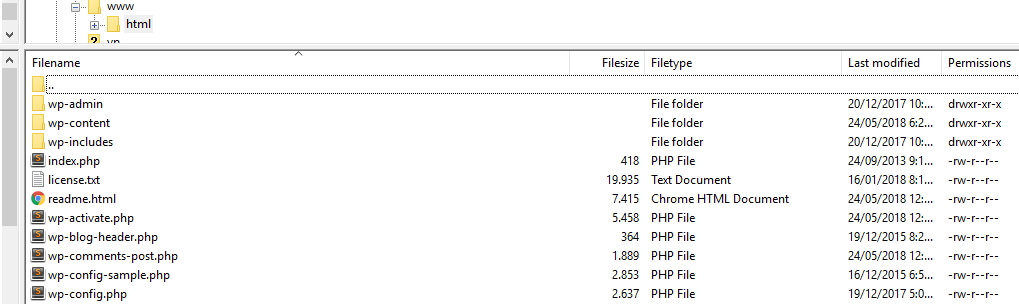

Тем не менее, вы можете добавить дополнительные правила в свой файл. Прежде чем вы сможете это сделать, вам необходимо понять, что это виртуальный файл. Как правило, местоположение файла WordPress robots.txt находится внутри вашего корневого каталога, который часто называется public_html или www (или содержит имя вашего сайта):

Однако файл robots.txt, который WordPress настраивает по умолчанию, вообще недоступен из любого каталога. Это работает, но если вы хотите внести в него изменения, вы должны создать свой собственный файл и загрузить его в корневую папку в качестве замены.

Мы рассмотрим несколько способов создания нового robots.txt для WordPress в ближайшее время. Однако сейчас давайте поговорим о том, как определить, какие правила следует включать в ваши.

В предыдущем разделе мы видели пример файла robots.txt, сгенерированного WordPress. В него включены только два коротких правила, но большинство веб-сайтов настраивают больше, чем это. Давайте посмотрим на два разных файла robots.txt и поговорим о том, что каждый из них делает по-своему.

Вот наш первый пример WordPress robots.txt :

User-agent: * Разрешить: / # Запрещенные подкаталоги Disallow: / checkout / Disallow: / images / Disallow: / forum /

Это общий файл robots.txt для веб-сайта с форумом. Поисковые системы часто индексируют каждую тему на форуме. Однако, в зависимости от того, для чего предназначен ваш форум, вы можете отказаться от него. Таким образом, Google не будет индексировать сотни сообщений о пользователях, которые ведут небольшую беседу. Вы также можете установить правила, которые определяют конкретные подфорумы, чтобы избежать, и позволяют поисковым системам отслеживать остальные.

Вы также увидите строку с надписью Allow: / в верхней части файла. Эта строка сообщает роботам, что они могут сканировать все страницы вашего сайта, кроме исключений, которые вы устанавливаете сразу. Таким же образом, вы заметите, что мы указываем, что эти правила универсальны (со звездочкой), так же, как это делает виртуальный robots.txt в WordPress.

Теперь давайте посмотрим на другой пример WordPress robots.txt :

Пользовательский агент: * Disallow: / wp-admin / Disallow: / wp-includes / User-agent: Bingbot Disallow: /

В этом файле мы настраиваем те же правила, что и WordPress по умолчанию. Тем не менее, мы также добавили новый набор правил, которые предотвращают Поисковый робот Bing отслеживать наш сайт. Bingbot, как вы можете себе представить, это имя этого робота.

Вы можете точно указать, какие роботы поисковых систем имеют доступ к вашему сайту, а какие нет. На практике, конечно, Bingbot довольно мягок (даже если он не такой крутой, как Googlebot). Тем не менее, есть несколько злых роботов.

Плохая новость заключается в том, что они не всегда следуют инструкциям в файле robots.txt (в конце концов, они мятежники). Стоит помнить, что, хотя большинство роботов будут следовать инструкциям, приведенным в этом файле, вы не будете заставлять их делать это. Вы просто мило спрашиваете.

Если вы прочитаете об этом, вы найдете много предложений о том, что разрешать и что блокировать на вашем веб-сайте WordPress. Однако, по нашему опыту, лучше иметь несколько правил. Вот пример того, как мы рекомендуем, чтобы это был ваш первый файл robots.txt :

User-Agent: * Разрешить: / wp-content / uploads / Disallow: / wp-content / plugins /

Традиционно WordPress любит блокировать доступ к каталогам wp-admin и wp-include . Однако это больше не считается хорошей практикой. Кроме того, если вы добавляете метаданные к своим изображениям для целей SEO, нет смысла запрещать роботам отслеживать эту информацию. Вместо этого два предыдущих правила охватывают то, что потребуется большинству основных сайтов.

Однако то, что вы включаете в файл robots.txt, будет зависеть от вашего сайта и ваших конкретных потребностей. Так что не стесняйтесь исследовать немного больше!

Как создать файл robots.txt в WordPress (3 метода)

После того, как вы решили, что включить в файл robots.txt , просто создайте его. Вы можете редактировать robots.txt в WordPress с помощью плагина или вручную. В этом разделе мы научим вас, как использовать два популярных плагина для этой работы, и проанализируем, как создать и загрузить файл самостоятельно. Давай!

1. Используйте Yoast SEO

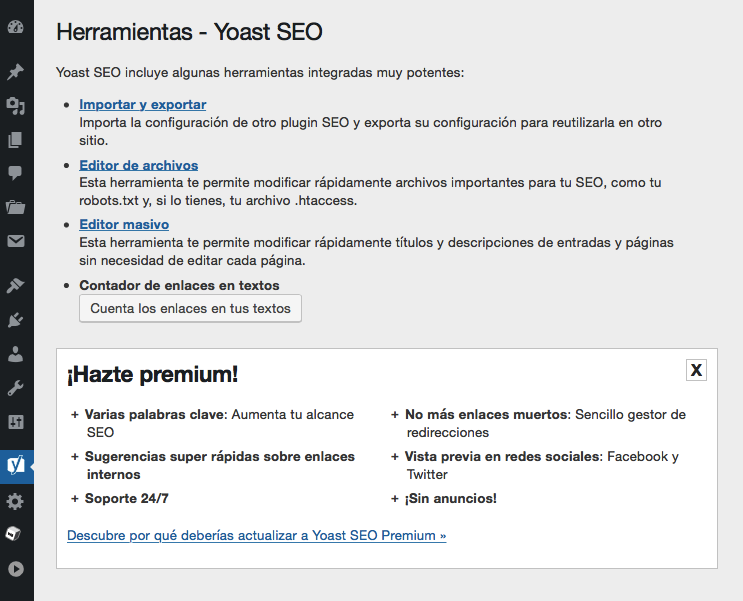

Yoast SEO не нуждается в представлении. Это самый популярный SEO плагин для WordPress, и он позволяет оптимизировать ваши посты и страницы, чтобы лучше использовать ваши ключевые слова. В дополнение к этому, он также предоставляет вам помощь, когда дело доходит до повышения читабельности вашего контента, что означает, что больше людей смогут наслаждаться им.

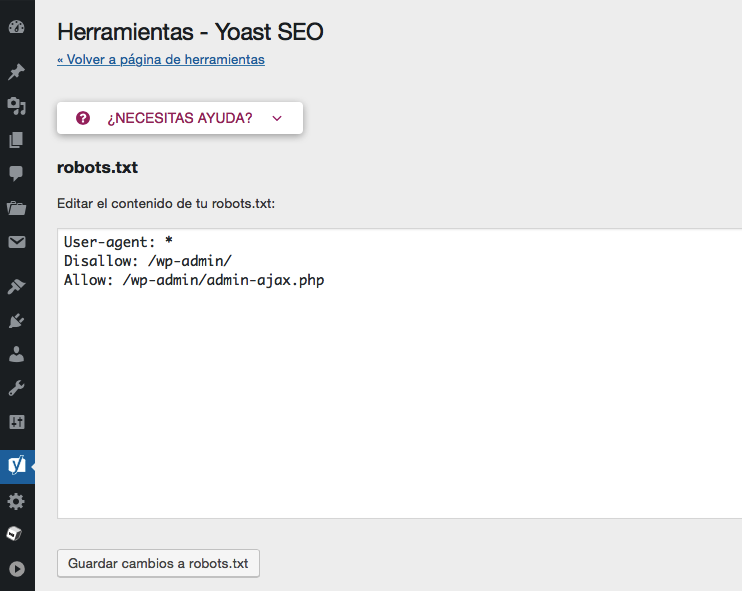

Лично мы поклонники Yoast SEO из-за простоты использования. Что также относится к созданию файла robots.txt . После установки и активации плагина перейдите на вкладку « SEO»> «Инструменты » на рабочем столе и найдите параметр « Редактор файлов» :

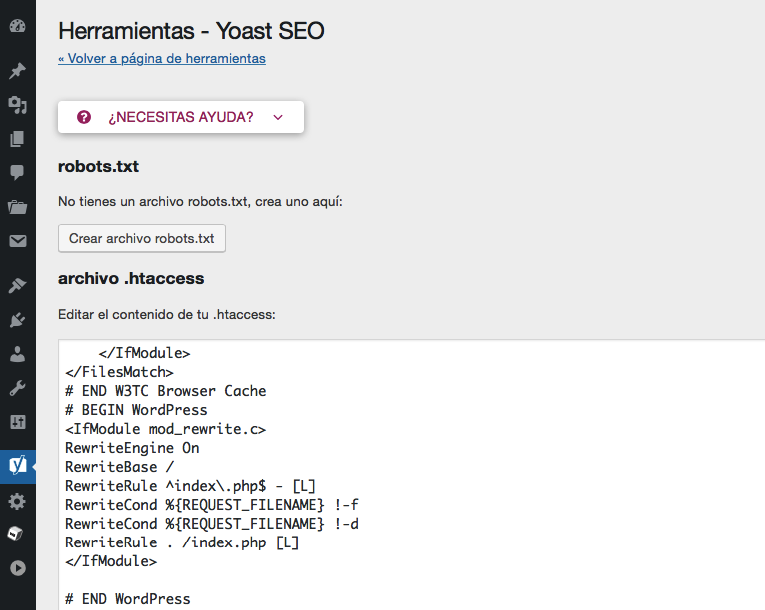

Когда вы щелкнете по этой ссылке, вы перейдете на новую страницу, где сможете редактировать свой файл .htaccess, не покидая рабочего стола. Также есть полезная кнопка с текстом Create robots.txt file , которая делает именно то, что говорит:

Когда вы нажмете эту кнопку, на вкладке появится новый редактор, в котором вы сможете напрямую изменить файл robots.txt . Обратите внимание, что Yoast SEO устанавливает свои собственные правила по умолчанию, которые переопределяют существующий виртуальный файл robots.txt .

Каждый раз, когда вы добавляете или удаляете правила, не забывайте нажимать кнопку « Сохранить изменения в файле robots.txt» , чтобы они применялись:

Это было достаточно просто! Теперь посмотрим, как другой популярный плагин делает то же самое.

2. С плагином Все в одном SEO Pack

Все в одном пакете SEO Это другое имя, известное, когда речь заходит о SEO в WordPress. Он включает в себя большинство функций, которые предлагает SEO Yoast, но некоторые люди предпочитают его, потому что это более легкий плагин. Что касается robots.txt , создание файла с этим плагином так же просто.

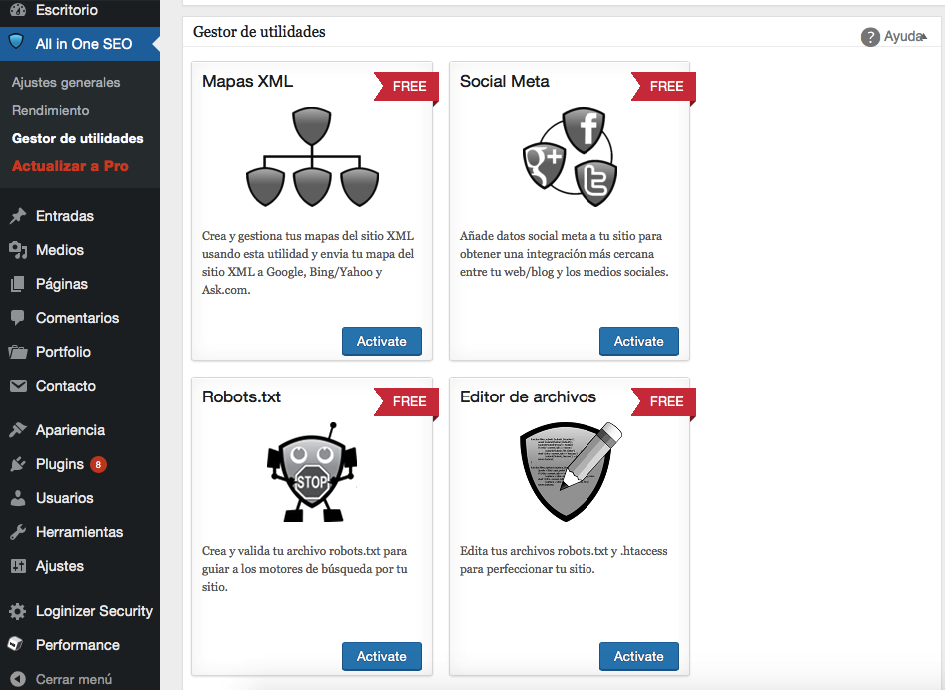

Когда у вас есть настроил плагин , перейдите на страницу Все в одном SEO> Utility Manager на вашем рабочем столе. Внутри вы найдете опцию Robots.txt , с кнопкой, видимой для активации чуть ниже. Нажмите на этот:

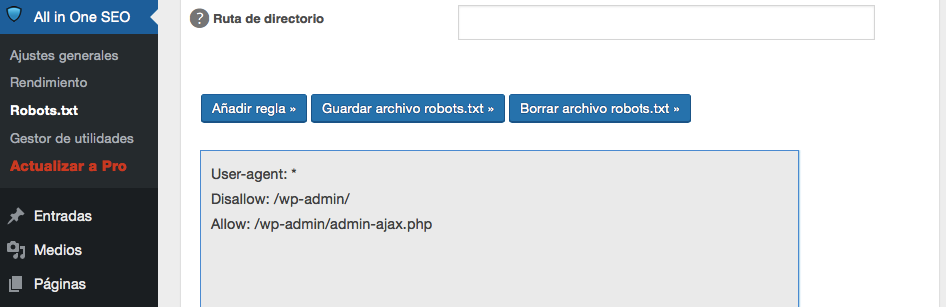

Теперь в вашем SEO- меню « Все в одном» появится новая вкладка Robots.txt . Если вы щелкнете по нему, вы увидите опции для добавления новых правил в ваш файл, сохранения внесенных вами изменений или полного удаления:

Обратите внимание, что вы не можете вносить изменения в файл robots.txt напрямую с помощью этого плагина. Сам файл отображается серым цветом, в отличие от Yoast SEO, который позволяет писать все, что вы хотите:

В любом случае, добавление новых правил очень просто, поэтому не позволяйте этому небольшому неудобству вас обескураживать. Что еще более важно, All in One SEO Pack также включает функцию, которая может помочь вам заблокировать «плохих» роботов, доступ к которым вы можете получить на вкладке « Все в одном »:

Это все, что вам нужно сделать, если вы выберете этот метод. Однако давайте поговорим о том, как создать файл robots.txt вручную, если вы не хотите настраивать дополнительный плагин только для того, чтобы позаботиться об этой задаче.

3. Создайте и загрузите файл WordPress robots.txt через FTP

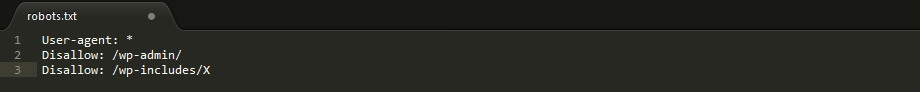

Создание текстового файла не может быть проще. Все, что вам нужно сделать, это открыть ваш любимый текстовый редактор (например, Блокнот или TextEdit) и написать пару строк. Затем вы можете сохранить файл, используя нужное имя и тип текстового файла. Это занимает буквально несколько секунд, поэтому имеет смысл редактировать robots.txt в WordPress без использования плагина.

Вот быстрый пример файла:

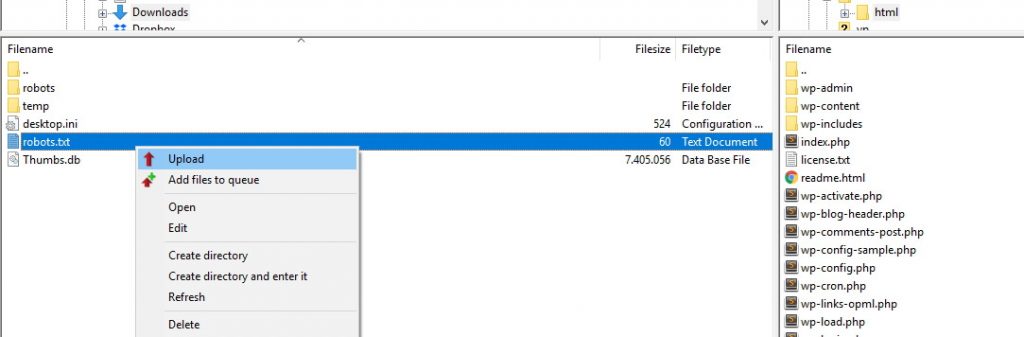

Для целей данного руководства мы сохраняем этот файл непосредственно на нашем компьютере. После того как вы создали и сохранили свой собственный файл, вы должны подключиться к своему веб-сайту через FTP , Если вы не уверены, как это сделать, у нас есть руководство, чтобы сделать это с помощью клиента FileZilla прост в использовании ,

Как только вы подключитесь к своему сайту, перейдите в папку public_html . Затем все, что вам нужно сделать, это загрузить файл robots.txt с вашего компьютера на ваш сервер. Вы можете сделать это, щелкнув правой кнопкой мыши файл, используя локальный браузер вашего FTP-клиента, или просто перетащив его и поместив его на место:

Загрузка файла займет всего несколько секунд. Как видите, этот метод почти так же прост, как и использование плагина.

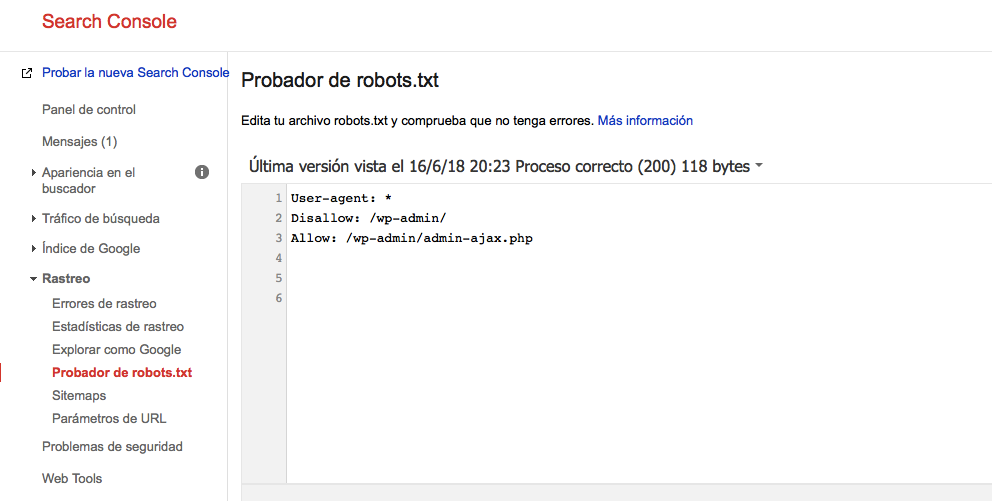

Как проверить файл WordPress robots.txt и отправить его в Google Search Console

После того как вы создали и загрузили файл WordPress robots.txt, вы можете использовать Google Search Console проверить это на ошибки. Поисковая консоль - это набор инструментов, которые Google предлагает, чтобы помочь вам отслеживать, как ваш контент отображается в результатах поиска. Одним из этих инструментов является верификатор robots.txt , который можно использовать, войдя в консоль и перейдя на вкладку тестера robots.txt в меню «Отслеживание»:

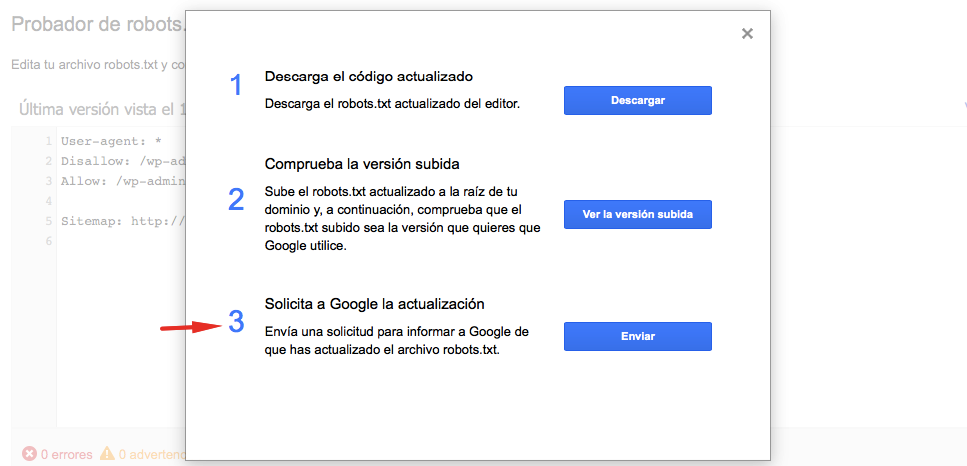

Внутри вы найдете поле редактора, в котором вы можете добавить код файла WordPress robots.txt и нажать кнопку « Отправить» чуть ниже. Google Search Console спросит вас, хотите ли вы использовать этот новый код или извлечь файл с вашего сайта. Нажмите на опцию, которая говорит Запросить Google обновить его, чтобы отправить его вручную:

Теперь платформа проверит ваш файл на наличие ошибок. Если он есть, он покажет это вам. Тем не менее, вы уже видели более одного примера WordPress robots.txt , так что очень вероятно, что ваш идеально подходит!

заключение

Чтобы увеличить посещаемость вашего сайта, вы должны убедиться, что роботы поисковых систем отслеживают наиболее актуальную информацию. Как мы видели, хорошо настроенный файл WordPress robots.txt позволит вам точно определить, как эти роботы взаимодействуют с вашим сайтом. Таким образом, они могут показывать поисковым системам более актуальный и полезный контент.

У вас есть вопрос о том, как редактировать robots.txt в WordPress? Расскажите нам в разделе комментариев!

Txt?Txt?